Tehisintellekt. Kui palju tema kohta on räägitud, aga me pole veel isegi veel rääkima hakanud. Peaaegu kõik, mida tehisintellekti edenemisest kuulete, põhineb läbimurdel, mis on kolmkümmend aastat vana. Edusammude säilitamiseks on vaja tõsistest ja suurtest piirangutest mööda hiilida. Järgmisena, esimeses isikus - James Somers.

Seisan seal, kus peagi asub maailma keskpunkt, või lihtsalt Toronto kesklinna läikiva torni seitsmendal korrusel asuvas suures toas - kummale poole te vaatate. Minuga on kaasas selle koha kaasasutaja Jordan Jacobs: Vektoriinstituut, mis avab oma uksed sel sügisel ja tõotab kujuneda tehisintellekti globaalseks epitsentriks.

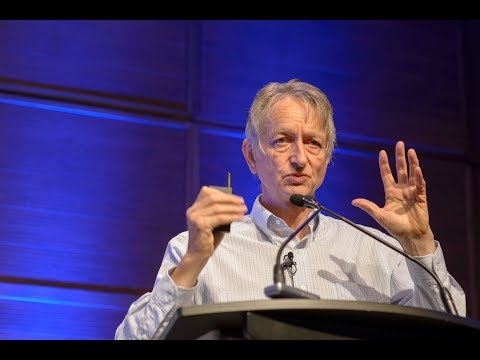

Oleme Torontos, sest Jeffrey Hinton on Torontos. Ja Jeffrey Hinton on "sügava õppimise" isa, AI hüpe taga oleva tehnika isa. "30 aasta pärast vaatame tagasi ja ütleme, et Jeff on AI sügava õppimise Einstein, ükskõik mida me kutsume tehisintellektiks," ütleb Jacobs. Kõigist AI uurijatest viidatakse Hintonile sagedamini kui teda järginud kolm. Tema bakalaureuse- ja magistriõppe üliõpilased lähevad tööle AI laborisse Apple, Facebook ja OpenAI; Hinton ise on Google Brain AI meeskonna juhtiv teadlane. Peaaegu igal AI edusammul viimase kümnendi jooksul - tõlkimises, kõnetuvastuses, pildituvastuses ja mängudes - on Hintoni loominguga midagi pistmist.

Vektorinstituut, mis on monument Hintoni ideede esilekerkimisele, on uurimiskeskus, kus USA-st ja Kanadast pärit ettevõtted - näiteks Google, Uber ja NVIDIA - toetavad jõupingutusi AI-tehnoloogiate turustamiseks. Raha kallab kiiremini, kui Jacobs seda küsib; kaks selle asutajat uurisid Toronto piirkonna ettevõtteid ning nõudmine AI ekspertide järele oli kümme korda suurem kui Kanada tarned igal aastal. Vektoriinstituut on teatud mõttes kasutamata neitsi maa, kus üritatakse mobiliseerida maailma sügava õppimise ümber: investeerida, õpetada, lihvida ja rakendada seda tehnikat. Rajatakse andmekeskusi, pilvelõhkujaid täidetakse idufirmadega ja piirkonda valab põlvkond tudengeid.

Kui vektori põrandal seisate, tekib tunne, et olete millegi alguses. Kuid sügav õppimine on selle keskmes väga vana. Hintoni läbimurdeline artikkel, mis on kirjutatud koos David Rumelharti ja Ronald Williamsiga, avaldati 1986. aastal. Töö kirjeldas lühidalt vea tagasi paljundamise meetodit (tagasipropagatsioon). Backprop on John Coheni sõnul "kõigel, mida sügav õppimine põhineb - kõigel".

Selle juured on AI tänapäeval sügav õppimine ja sügav õppimine on tagasitulek. Mis on jahmatav, kui arvestada, et seljatugi on üle 30 aasta vana. Lihtsalt on vaja mõista, kuidas see juhtus: kuidas saaks tehnoloogia nii kaua oodata ja siis plahvatuse põhjustada? Sest kui teate tagasivaate ajalugu, saate aru, mis AI-ga praegu toimub, ja ka sellest, et me ei pruugi olla revolutsiooni alguses. Võib-olla oleme ühe lõpus.

Jalutuskäik Vektoriinstituudist Hintoni Google'i kontorisse, kus ta veedab suurema osa ajast (nüüd on ta Toronto ülikooli emeriitprofessor), on linnale omamoodi reaalajas reklaam, vähemalt suvel. Saab selgeks, miks Hinton, kes on pärit Suurbritanniast, kolis siia 1980. aastatel pärast tööd Pittsburghis Carnegie Melloni ülikoolis.

Reklaamvideo:

Võib-olla pole me revolutsiooni päris alguses

Toronto on Põhja-Ameerika suuruselt neljas linn (Mehhiko, New Yorgi ja Los Angelese järel) ning kindlasti mitmekesisem: üle poole elanikkonnast sündis väljaspool Kanadat. Ja näete seda linnas ringi kõndides. Rahvas on rahvusvaheline. Seal on tasuta tervishoid ja head koolid, inimesed on sõbralikud, poliitikud on suhteliselt vasakpoolsed ja stabiilsed; kõik see köidab inimesi nagu Hinton, kelle sõnul lahkus ta Iraani värava tõttu USA-st (Iraan-Contra on USA-s 1980. aastate teisel poolel suur poliitiline skandaal; siis sai teada, et USA administratsiooni teatud liikmed korraldasid salajasi relvade tarnimine Iraanile, rikkudes sellega selle riigi relvaembargot). Siit algab meie vestlus enne lõunat.

"Paljud arvasid, et USA võib Nicaraguasse tungida," ütleb ta. "Mingil põhjusel uskusid nad, et Nicaragua kuulub Ameerika Ühendriikidesse." Ta ütleb, et tegi hiljuti projektis suure läbimurde: “Minuga hakkas tööle väga hea nooreminsener,” nimetas naine nimega Sarah Sabour. Sabur on iraanlane ja tal ei ole USA-s töötamiseks viisat antud. Google'i Toronto kontor tõmbas selle välja.

Hinton on 69-aastane. Tal on terav, õhuke inglise keel, õhuke suu, suured kõrvad ja uhke nina. Ta on sündinud Wimbledonis ja meenutab vestlusega lasteraamatu jutustajat teadusest: uudishimulik, köitev, püüab kõike selgitada. Ta on naljakas ja mängib natuke publikule. Seljaprobleemide tõttu on tal valus istuda, seetõttu ei saa ta lennata ning hambaarsti kabinetis lamab ta surfilauda meenutaval seadmel.

1980ndatel oli Hinton, nagu ta praegu on, närvivõrkude ekspert, meie aju neuronite ja sünapside võrgu oluliselt lihtsustatud mudel. Omal ajal oldi aga kindlalt nõus, et närvivõrgud on AI uurimise ummiktee. Ehkki päris esimene närvivõrk, Perceptron, töötati välja 1960. aastatel ja seda peeti esimeseks sammuks inimese tasemel masinluure poole, tõestasid Marvin Minsky ja Seymour Papert 1969. aastal matemaatiliselt, et sellised võrgud suudavad täita vaid lihtsaid funktsioone. Nendel võrkudel oli ainult kaks neuronikihti: sisend- ja väljundkiht. Võrgud, milles on palju kihte sisend- ja väljundneuronite vahel, võiksid teoreetiliselt lahendada mitmesuguseid probleeme, kuid keegi ei teadnud, kuidas neid treenida, nii et praktikas olid need kasutud. Perceptronite tõttu on peaaegu kõik mõne erandiga närvivõrkude ideest loobunud.sealhulgas Hinton.

Hintoni läbimurre 1986. aastal oli näidata, et tagasi paljunemine võib treenida sügavat närvivõrku, milles on rohkem kui kaks või kolm kihti. Kuid arvutivõimsuse suurenemiseni kulus veel 26 aastat. 2012. aasta paberlehes näitasid Hinton ja kaks Toronto õpilast, et sügava närvivõrgustikuga, mida treeniti koos tagapõhjaga, edestati parimaid pildituvastussüsteeme. Sügav õppimine on hakanud veojõudu saama. Maailm otsustas üleöö, et AI võtab hommikul vara üle. Hintoni jaoks oli see tervitatav võit.

Tegelikkuse moonutamise väli

Neuraalvõrku kujutatakse tavaliselt võileibina, mille kihid asetsevad üksteise peal. Need kihid sisaldavad tehisneuroneid, mis on sisuliselt väikesed arvutusüksused, mis tulistavad - nagu päris neuron - ja edastavad selle erutuse teistele neuronitele, millega nad on ühendatud. Neuroni ergastust tähistab arv, näiteks 0,13 või 32,39, mis määrab neuroni ergastuse määra. Ja mõlemal kahe neuroni ühendusel on veel üks oluline arv, mis määrab, kui palju erutust tuleks ühelt teisele üle kanda. See arv modelleerib aju neuronite vaheliste sünapside tugevust. Mida suurem arv, seda tugevam on ühendus, mis tähendab, et rohkem põnevust voolab ühelt teisele.

Sügavate närvivõrkude üks edukamaid rakendusi on olnud pildi tuvastamine. Täna on programme, mis tunnevad ära, kas pildil on hot dog. Mõni kümme aastat tagasi olid need võimatud. Nende toimimiseks peate kõigepealt pildi tegema. Ütleme lihtsuse huvides, et see on 100x100 piksline mustvalge pilt. Söödate selle närvivõrku, määrates sisestuskihis iga simuleeritud neuroni tulistamise nii, et see võrdub iga piksli heledusega. See on võileiva alumine kiht: 10 000 neuroni (100 x 100), mis tähistab iga pildi piksli heledust.

Siis ühendate selle suure neuronikihi teise suure neuronikihiga, juba kõrgemaga, ütleme, paar tuhat, ja need omakorda teise, mitme tuhandest neuronist koosneva kihiga, kuid vähem jne. Lõpuks koosneb võileiva ülemine kiht - väljundkiht - kahest neuronist - üks esindab kuuma koera ja teine mitte kuuma koera. Idee on koolitada närvivõrku nii, et see vallandaks ainult esimese neist neuronitest, kui pildil on hot dog, ja teise, kui seda pole. Backprop, backpropagatsioonitehnika, millele Hinton on oma karjääri rajanud, teeb just seda.

Backprop on äärmiselt lihtne, ehkki kõige paremini töötab see tohutul hulgal andmeid. See on põhjus, miks suurandmed on AI-le nii olulised - miks Facebook ja Google on selle vastu nii kirglikud ning miks otsustas Vector Institute luua ühenduse Kanada nelja suurima haiglaga ja jagada andmeid.

Sel juhul on andmed miljonite piltide kujul, mõnel juhul on tegemist kuumade koertega, mõnel puudub; trikk on märkida need pildid kuumade koertega. Neuraalvõrgu esmakordsel loomisel on neuronite vahelistel ühendustel juhuslikud kaalud - juhuslikud numbrid, mis ütlevad, kui palju erutust edastatakse iga ühenduse kaudu. Justkui pole aju sünaps veel häälestatud. Seljatoe eesmärk on muuta neid kaalu nii, et võrk toimiks: nii, et kui söödate kuuma koera kujutise kõige alumisse kihti, siis tulistab ülemises kihis olev kuuma koera neuron.

Oletame, et tegite esimese klaveriõppe pildi. Te teisendate 100 x 100 pildi piksli intensiivsuse 10 000 numbriks, üks võrgu alumise kihi iga neuroni kohta. Kuna erutus levib võrgus vastavalt külgnevate kihtide neuronite ühenduse tugevusele, jõuab kõik järk-järgult viimasele kihile - ühele kahest neuronist, mis määravad, kas pildil on hot dog. Kuna see on pilt klaverist, peaks hot-dogi neuron näitama nulli ja mitte-hot-dogi neuron näitama suuremat arvu. Ütleme nii, et asjad ei tööta niimoodi. Ütleme, et võrk eksis pildi osas valesti. Backprop on protseduur võrgu iga ühenduse tugevuse tugevdamiseks, võimaldades antud koolitusnäites vea parandada.

Kuidas see töötab? Alustate kahe viimase neuroniga ja saate aru, kui valesti nad on: mis vahe on nende tulistamisnumbritel ja mis see tegelikult peaks olema. Siis vaatate iga ühendust, mis viib nende neuroniteni - minnes mööda kihte - ja määrake nende panus veasse. Teete seda seni, kuni jõuate esimese ühenduste komplekti juurde võrgu kõige põhjas. Sel hetkel teate, kuidas individuaalne ühendus aitab kaasa üldise vea tekkele. Lõpuks muudate kõiki kaalu, et vähendada üldist veavõimalust. See niinimetatud "vigade levitamise tehnika" seisneb selles, et veate vigu võrgu kaudu tagasi, alustades tagant, välja.

Uskumatu hakkab juhtuma siis, kui teete seda miljonite või miljardite piltidega: võrk hakkab hästi määrama, kas pilt on hot dog või mitte. Ja mis on veelgi tähelepanuväärsem, on see, et nende pildituvastusvõrkude üksikud kihid hakkavad pilte "nägema" samamoodi nagu meie oma visuaalsüsteem. See tähendab, et esimene kiht tuvastab kontuurid - neuronid vallandatakse siis, kui kontuurid on olemas, ja ei vallandata, kui neid pole; järgmine kiht määratleb teede komplektid, näiteks nurgad; järgmine kiht hakkab vorme eristama; järgmine kiht leiab kõikvõimalikke elemente nagu "avatud kakuke" või "suletud kakuke", kuna vastavad neuronid on aktiveeritud. Võrk jaguneb hierarhilisteks kihtideks, ilma et oleksite sel viisil programmeeritud.

Tõeline intelligentsus pole segane, kui probleem pisut muutub.

See hämmastas kõiki nii väga. Asi pole mitte niivõrd selles, et närvivõrgud on head hot dogi piltide klassifitseerimisel: nad ehitavad ideede representatsioone. Tekstiga muutub see veelgi ilmsemaks. Saate sööta Vikipeedia teksti, palju miljardeid sõnu, lihtsasse närvivõrku, õpetades seda andma igale sõnale numbrid, mis vastavad kihi iga neuroni erutustele. Kui mõelda kõigile numbritele keerulises ruumis koordinaatidena, leiate iga ruumis oleva sõna jaoks punkti, mida selles kontekstis tuntakse vektorina. Seejärel koolitate võrku nii, et Vikipeedia lehtedel kõrvuti ilmuvatele sõnadele antakse sarnased koordinaadid - ja voila, juhtub midagi kummalist: samas ruumis ilmuvad sarnaste tähendustega sõnad üksteise kõrval. "Hull" ja "ärritunud" jäävad sinna; "Kolm" ja "seitse" ka. Lisaksvektori aritmeetika võimaldab lahutada vektorist "Pariis" vektori "Prantsusmaa", lisada see "Itaalia" ja leida läheduses "Rooma". Keegi ei öelnud närvivõrgustikule, et Rooma on Itaalia jaoks sama, mis Pariis on Prantsusmaa jaoks.

"See on hämmastav," ütleb Hinton. "See on šokeeriv." Neuraalvõrgustikke võib vaadelda kui katset võtta asju - pilte, sõnu, vestluste salvestisi, meditsiinilisi andmeid - ja paigutada need, nagu matemaatikud ütlevad, mitmemõõtmelisse vektoriruumi, milles asjade lähedus või kaugus peegeldab reaalmaailma kõige olulisemaid aspekte. Hinton usub, et just seda aju teebki. "Kui soovite teada, mis mõte on," ütleb ta, "võin selle teile sõnade seeriana edastada. Võin öelda: "John arvas" ohoo. " Aga kui te küsite: mida mõeldakse? Mida tähendab Johannesel see mõte? Lõppude lõpuks pole tema peas ühtegi avapakkumist, "oih", sulgevat tsitaati, üldiselt sellist asja pole. Tema peas toimub mingi närvitegevus. " Kui olete matemaatik, võib närvitegevuse suuri pilte jäädvustada vektorruumi,kus iga neuroni aktiivsus vastab numbrile ja iga arv vastab väga suure vektori koordinaadile. Hintoni jaoks on mõte vektorite tants.

Nüüd on selge, miks vektori instituuti seda kutsuti?

Hinton loob omamoodi reaalsuse moonutamise välja, teile edastatakse enesekindluse ja entusiasmi tunne, sisendades usku, et vektorite jaoks pole miski võimatu. Lõppude lõpuks on nad juba loonud isesõitvaid autosid, vähktõbe tuvastavaid arvuteid, viivitamatu kõnekeele tõlke.

Alles ruumist lahkudes mäletate, et need sügava õppesüsteemid on vaatamata nende demonstreeritavale mõttejõule endiselt üsna lollid. Näib, et arvuti, mis näeb lauale hunnikut sõõrikut ja märgib selle automaatselt kui hunniku sõõrikuid lauale, näib mõistvat maailma; aga kui sama programm näeb tüdrukut hambaid pesevat ja ütleb, et ta on „pesapallikurikaga poiss”, saate aru, kui keeruline on see arusaam, kui seda üldse on.

Neuraalvõrgud on lihtsalt mõistusevastased ja ebamäärased mustrituvastajad ning kui kasulikud sellised mustrituvastajad võivad olla - püüavad nad ju neid suvalisse tarkvara integreerida -, need on parimal juhul piiratud intelligentsusega tõug, mida on hõlpsasti trükkimas. Pilte tuvastav sügav närvivõrk võib olla täiesti segane, kui muudate ühte pikslit või lisate visuaalse müra, mis on inimestele nähtamatu. Peaaegu sama sageli, kui leiame uusi võimalusi sügava õppimise kasutamiseks, seisame sageli silmitsi selle piirangutega. Isesõitvad autod ei saa sõita tingimustes, mida varem pole nähtud. Masinad ei saa sõeluda lauseid, mis nõuavad mõistust ja mõistmist, kuidas maailm töötab.

Deep Learning jäljendab inimese ajus toimuvat viisil, kuid pealiskaudselt - mis võib-olla seletab, miks tema intelligentsus on kohati nii pealiskaudne. Aju keelekümbluse ajal selgroogu ei avastatud, üritades mõtet ise dešifreerida; see kasvas välja loomade õppimise mudelitest katse-eksituse meetodil vanamoodsates katsetes. Ja enamus olulisi samme, mis selle asutamise algusest peale on tehtud, ei sisaldanud neuroteaduses midagi uut; need olid tehnilised parandused, mille väärisid matemaatikute ja inseneride aastatepikkune töö. See, mida me intelligentsuse kohta teame, pole midagi võrreldes sellega, mida me selle kohta veel ei tea.

Toronto ülikooli Hintoniga samas osakonnas tegutseva abiprofessori David Duvenaudi sõnul sarnaneb sügav õppimine enne füüsika tutvustamist inseneriteadustega. "Keegi kirjutab teose ja ütleb:" Ma tegin selle silla ja see on seda väärt! " Teine kirjutab: "Ma tegin selle silla ja see varises kokku, kuid lisasin toed ja see seisab." Ja kõigil läheb tugede pärast hulluks. Keegi lisab kaare - ja kõik on sellised: kaared on lahedad! Füüsika abil saate tegelikult aru saada, mis töötab ja miks. Oleme alles hiljuti hakanud liikuma vähemalt tehisintellekti teatud mõistmise poole."

Ja Hinton ise ütleb: “Enamikul konverentsidel räägitakse väikeste muudatuste tegemisest selle asemel, et mõelda kõvasti ja esitada küsimusi:“Miks see, mida me praegu teeme, ei tööta välja? Mis on selle põhjus? Keskendume sellele."

Välist vaatenurka on raske saada, kui kõik, mida näete, on edasiminek pärast edasiliikumist. Kuid viimased AI edusammud on olnud vähem teaduslikud ja rohkem inseneriteadused. Ehkki meil on parem arusaam sellest, millised muudatused täiustavad süvaõppe süsteeme, on meil siiski ebamäärane ettekujutus, kuidas need süsteemid toimivad ja kas need võivad kunagi kokku tulla millekski nii võimsaks kui inimmõistus.

Oluline on mõista, kas suutsime tagaistmest välja võtta kõik, mis võimalik. Kui jah, siis on meil tehisintellekti arendamisel platoo.

Kannatlikkust

Kui soovite näha järgmist läbimurret, midagi palju paindlikuma intelligentsusega masinate raamistiku taolist, peaksite teoreetiliselt pöörduma 80-ndate aastate backprop-uuringutega sarnase uurimistöö poole: kui arukad inimesed loobusid, kuna nende ideed ei töötanud veel. …

Mõni kuu tagasi külastasin MIT-is asuvat mitmeotstarbelist asutust Minds, Brain and Machines, et vaadata, kuidas mu sõber Eyal Dechter kaitseb oma väitekirja kognitiivteaduse alal. Enne etenduse algust toetasid teda abikaasa Amy, koer Ruby ja tütar Suzanne ning soovisid talle õnne.

Eyal alustas oma kõnet põneva küsimusega: kuidas juhtus, et vaid kaheaastane Suzanne õppis rääkima, mängima, lugusid jälgima? Mis on inimese ajus see, mis võimaldab tal nii hästi õppida? Kas arvuti õpib kunagi nii kiiresti ja sujuvalt õppima?

Mõistame uusi nähtusi juba mõistetavate asjade kaudu. Jagame domeeni tükkideks ja uurime seda tükkhaaval. Eyal on matemaatik ja programmeerija, ta arvab, et keerukate arvutiprogrammidena on ülesanded - nagu näiteks sufli tegemine -. Kuid te ei õpi suflee valmistamist, kui jätate meelde sadu minutilisi programmijuhiseid, nagu näiteks "keerake küünarnukki 30 kraadi, siis vaadake lauaplaati, sirutage siis sõrme, siis …". Kui peaksite seda igal uuel juhul tegema, muutuks õppimine väljakannatamatuks ja lõpetaksite arenemise. Selle asemel näeme programmis selliseid kõrgetasemelisi samme nagu „valgete peksmine“, mis ise koosnevad alamprogrammidest nagu „murra munad“ja „eralda valged munakollastest“.

Arvutid seda ei tee ja tunduvad seetõttu rumalad. Kuumkoera äratundmise sügavaks õppimiseks peate talle söötma 40 miljonit kuuma koera pilti. Mida Suzanne hotdogi ära tundis, näidake talle lihtsalt seda hot dogi. Ja kaua enne seda saab ta keeleoskuse, mis läheb palju sügavamale kui eraldi sõnade üheskoos ilmumise äratundmine. Erinevalt arvutist on tema peas ettekujutus maailma toimimisest. "Mind üllatab, et inimesed kardavad, et arvutid võtavad oma töö," ütleb Eyal. “Arvutid ei saa advokaate asendada, kuna advokaadid teevad midagi keerulist. Aga sellepärast, et juristid kuulavad ja räägivad inimestega. Selles mõttes oleme sellest kõigest väga kaugel."

Tõeline intelligentsus ei lähe segadusse, kui muudate pisut probleemi lahendamise nõudeid. Ja Eyali põhiliseks lõputööks oli põhimõtteliselt täpselt seda demonstreerida, kuidas panna arvutit sellisel viisil tööle: rakendage uute probleemide lahendamiseks elavalt kõike, mida ta juba teab, haarata kiiresti lennult, saada eksperdiks täiesti uuel alal.

Põhimõtteliselt nimetab ta seda uurimise-pakkimise algoritmiks. See annab arvutile programmeerija funktsiooni, ehitades korduvkasutatavate moodulkomponentide raamatukogu, et saaks luua keerukamaid programme. Teadmata uuest domeenist midagi, proovib arvuti struktureerida selle kohta teadmisi, uurides seda lihtsalt, kinnistades avastatud ja uurides seda nagu laps.

Tema nõunik Joshua Tenenbaum on üks enim tsiteeritud AI uurijaid. Tenenbaumi nimi kerkis esile pooltes vestlustes, mis mul teiste teadlastega olid. Tema all on töötanud mõned DeepMindi võtmeisikud - AlphaGo arendusmeeskond, kes legendaarselt võitis 2016. aastal maailmameistri maailmameistri. Ta on seotud startupiga, mis üritab isesõitvatele autodele anda füüsika põhialustest ja teiste autojuhtide kavatsustest intuitiivne arusaam, et nad oskaksid paremini ette näha toimuvat olukordades, mida pole varem kohanud.

Eyali väitekirja pole praktikas veel rakendatud, seda pole isegi programmidesse sisse viidud. "Probleemid, millega Eyal töötab, on väga-väga rasked," ütleb Tenenbaum. "Möödub mitu põlvkonda."

Kui istusime kohvitassi järele, ütles Tenenbaum, et uurib inspiratsiooni saamiseks seljatoe ajalugu. Juba aastakümneid on backprop olnud laheda matemaatika vorm, enamik sellest pole võimeline millekski. Kuna arvutid said kiiremaks ja tehnoloogia raskemaks, muutusid asjad. Ta loodab, et tema enda ja õpilaste tööga juhtub midagi sarnast, kuid "selleks võib kuluda veel paarkümmend aastat."

Hintoni jaoks on ta veendunud, et AI piirangutest ülesaamine tähendab "silla loomist arvutiteaduse ja bioloogia vahel". Backprop oli sellest vaatepunktist bioloogiliselt inspireeritud andmetöötluse triumf; idee ei tulnud algselt mitte insenerist, vaid psühholoogiast. Nüüd proovib Hinton seda trikki korrata.

Tänapäeval koosnevad närvivõrgud suurtest lamedatest kihtidest, kuid inimese neokorteksis rivistuvad reaalsed neuronid veergudena mitte ainult horisontaalselt, vaid ka vertikaalselt. Hinton arvab, milleks need veerud mõeldud on - näiteks nägemises võimaldavad need teil objekte ära tunda isegi siis, kui muudate oma vaatepunkti. Nii loob ta selle teooria kontrollimiseks kunstliku versiooni - ja nimetab neid "kapsliteks". Siiani ei tule midagi välja: kapslid pole tema võrkude jõudlust märkimisväärselt parandanud. Kuid 30 aastat tagasi oli sama asi backprop-iga.

"See peaks toimima," ütleb ta kapsliteooria kohta ja naerab enda bravado üle. "Ja mis veel ei toimi, on vaid ajutine ärritus."

Medium.com materjalide põhjal

Ilja Khel